生成AIはなぜ“もっともらしくウソ”をつく?——『ハルシネーション』とは【原因と対策】

生成AIの“もっともらしい誤情報(ハルシネーション)”とは何か。原因・見抜き方・対策(SIFT/だ・い・ふく/RAG)を、物語→結論→実践で解説。

通勤電車で「レポートの根拠」を急いで確認。

AIに聞いたら自信満々の回答。でも、出典を開くと見当たらない引用や微妙に違う数字……。

「え、どっちが正しいの?」と、胸がざわつきます。

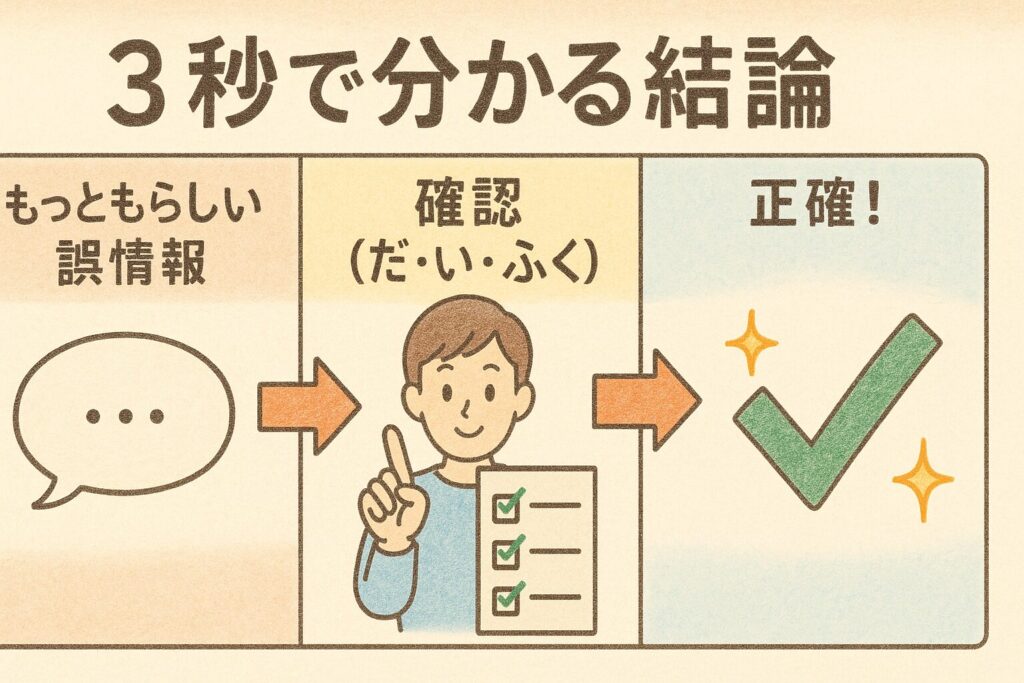

3秒で分かる結論

お答えします。

この現象は**「ハルシネーション」です。生成AIがもっともらしいのに事実でない情報を出すこと。完全な防止は、現時点の技術ではまだ困難と各種ガイドラインや研究でも整理されています。対策は出典確認(SIFT/だ・い・ふく)と根拠に結びつける使い方(RAGなど)**です。

今回の現象とは?

ふしぎ。

AIに質問すると、口調は完璧なのに根拠が見当たらない。

「ナンデ?」と感じる**“作り話っぽさ”**こそ、ハルシネーションです。

キャッチフレーズ風・よくある疑問

- 「自信満々なのに間違うのは、どうして?」(法則:最も自然な文を優先する仕組みが、真偽の判断より先に働く)

- 「“それっぽい出典”をAIが出すのは、なぜ?」(法則:文脈の穴埋めが過度に働くと、実在しない引用も生まれる)

- 「ウソをついているつもりはあるの?」(法則:故意ではなく確率。分からないなら沈黙とは限らない)

このようなことはありませんか?

- 参考文献・URLが存在しない/該当箇所がない

- 有名人の“名言”が見つからない(検索しても一次情報に辿りつけない)

- 日付・数値・地名が微妙にズレているのに、文章だけは流麗

- 「結論は正しそう」だが、根拠リンクの中身が別の話になっている

この記事を読むメリット

- 誤情報に振り回されない確認手順(SIFT / だ・い・ふく)が身につきます。

- 仕事・勉強・子育てで安全にAIを使う具体ワザが分かります。

- 企業・学校導入で注目の**“根拠に結びつける運用”(RAGなど)**も理解できます。

疑問が生まれた物語

締切前の夕方。

あなたは電車の揺れに合わせてスマホを握りしめ、AIにこう訊きます。

「この法律、例外ある?」——返ってきたのは頼もしげな答え。

でもリンクを開くと、同じ文言が見つからない。別のサイトでは違う日付。

「……どうして? どれが本当?」不安と好奇心が同時にふくらみます。

電車はゆっくりとトンネルに入り、窓の外が黒く沈みます。

胸の奥だけがざわついて、スマホの画面がやけにまぶしく見えます。

なんで“自信満々の言葉”なのに、根拠は見つからないんだろう。

こんな気持ちになるのは、正しい答えに手が届きそうで届かないからかもしれません。

たしかめたい。間違いなら直したい。

——このモヤモヤに名前があるなら、まずはそれを知るところから。

次へ進んで、“違和感の正体”をいっしょにほどいていきましょう。

すぐに分かる結論

お答えします。

この現象は『ハルシネーション』です。

生成AIがもっともらしいのに事実でない、ことを述べてしまう振る舞いで、現状は完全解決が難しい課題と各研究・ガイドラインに明記されています。

噛み砕いていうなら

AIは“言葉のつながりを予測する名人”ですが、本当かどうかを自動で確かめる名人ではありません。だから、ときどきそれらしい作り話が混ざります。

- なぜ自信満々で間違う? → 仕組み上、自然な文章を出す確率が優先され、不確実なら沈黙とは限らないから。

- なぜ“それっぽい出典”が出る? → 文脈の穴埋めが過度に働き、存在しない引用を“整合的に”作ってしまうことがあるから。

『もっともらしさ』の裏側にある仕組みと、日常で回せる検証の型を、これからいっしょに深掘りしましょう。

ショートFAQ

Q1. ハルシネーションは“嘘”と同じですか?

A. 意図的な嘘ではありません。 LLMは「自然に見える言葉」を確率で選ぶ仕組みのため、分からなくても“それらしく埋める”ことがあります。だからこそ出典確認が必要です。

Q2. URLを読み込ませれば安全?

A. いいえ。 要約や抽出の過程で誤読/補完しすぎが起きます。原文の該当箇所と更新日を必ず確認してください(=根拠へジャンプ)。

Q3. 一次情報って具体的に何?

A. 元データや公式原文です(官公庁の統計、法令データ、学会の論文PDFなど)。検索演算子 site:go.jp filetype:pdf が有効です。

Q4. すぐできる見抜き方は?

A. 「だ・い・ふく」(だれ/いつ/複数)+90秒タイマー。まず発信者→日付→別ソースの順で確認すれば、露骨な誤情報は大きく減ります。

『ハルシネーション』とは?

定義

ハルシネーション(Hallucination/ハルシネーション)とは、生成AIが流暢でそれらしく見えるのに、事実と異なる、または根拠に忠実でない内容を出してしまう現象です。

研究では大きく次の2軸で説明します。

- 事実性(Factuality/ファクチュアリティ):現実の事実や検証可能な知識と食い違う誤り。

- 忠実性(Faithfulness/フェイスフルネス):与えられた入力(本文・資料・プロンプトなど)に忠実でない誤り。

この二分法は大規模言語モデル(LLM)の総説でも一般的な整理です。

→定義がつかめたところで、**この言葉がどこから来たのか(由来)**を見てみましょう。

由来

「ハルシネーション」は**人間の“幻覚”**にたとえた比喩です。

機械翻訳(NMT:ニューラル・マシン・トランスレーション)や自動要約の研究で、入力にない内容を“もっともらしく付け足す”ふるまいを指す言葉として2010年代後半から広く定着しました。

提唱・初期の本格的な言及

- 機械翻訳での分析:Leeら(2018)は、入力に1語足すだけで訳全体が破綻するような“ハルシネーション的挙動”を報告し、入力にない内容の生成を体系的に検証しました。

- 要約での分析:Maynezら(ACL 2020)は、抽象要約(アブストラクティブ・サマライゼーション)が入力に不忠実な内容を生みやすいことを大規模人手評価で示し、Factuality/Faithfulnessという評価観点の重要性を明確化しました。

- LLM時代の整理:近年の総説(Huang ほか, 2023)は、原因・検出・軽減を包括的にレビューし、完全解決には至っていない現状を指摘しています。a

※噛み砕き:

**「分からないときに黙る」より「推測してでも答える」**ように学習・評価が設計されがちなことも、**過剰な“もっともらしさ”**の背景にあります(OpenAI研究チームの分析)。

実例

米国の裁判では、弁護士がAIの“架空の判例”を誤って引用し、制裁金を科される事態になりました(Mata v. Avianca, 2023)。「もっともらしさ」だけでは実務に耐えないことを示す象徴的な例です。

用語メモ

SIFT(シフト)

「ネット情報を素早く見極める4ステップ」

- Stop(ストップ:まず立ち止まる)

- Investigate the source(インベスティゲイト:**誰が言った?**を確認)

- Find better coverage(ファインド・ベター・カバレッジ:より良い別ソースを探す)

- Trace to the original(トレース:一次情報にさかのぼる)

大学の図書館ガイドでも同じ手順として紹介されています。

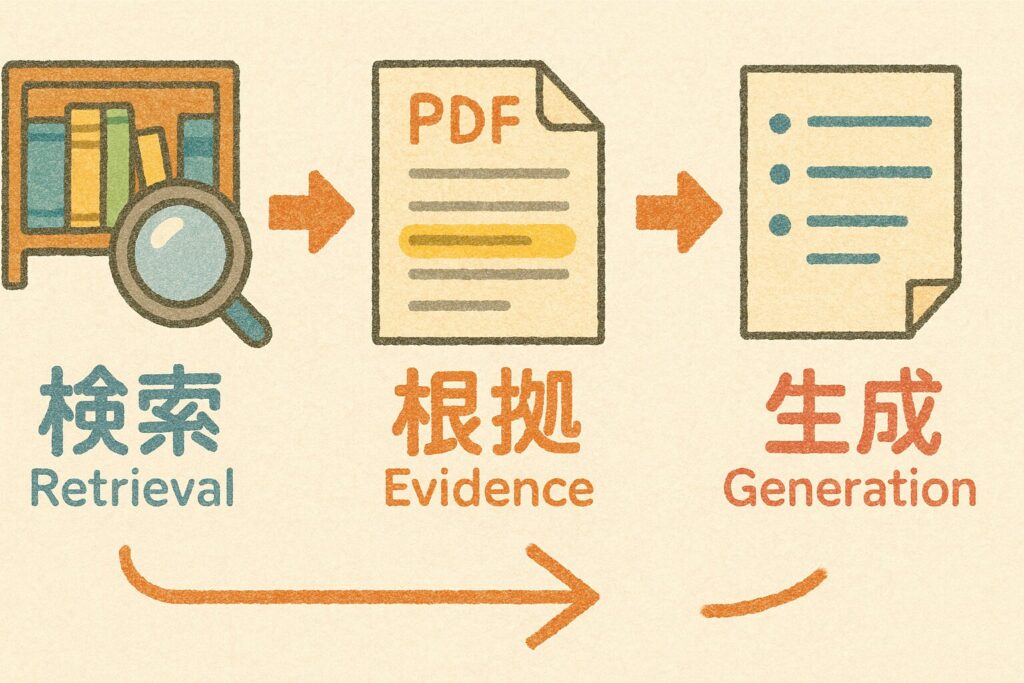

RAG(ラグ:Retrieval-Augmented Generation/リトリーバル・オーグメンテッド・ジェネレーション)

生成の前に“検索で根拠”を取りに行く仕組み。

AIが外部の信頼情報(例:Wikipediaや社内文書)を**検索(Retrieval)→根拠つきで生成(Generation)**する設計で、事実性の向上が報告されています

※噛み砕き

SIFT=人があとから確かめる型。

RAG=AIが前もって根拠を取りに行く仕組み。

目的は同じ——“もっともらしいだけ”を避けることです。

→いよいよ次章では、なぜ起きるのか(原因)とどう減らすのか(対策)を、SIFTの具体手順とRAGの活用イメージで分かりやすく解説します。

なぜ注目されるのか?

社会で急拡大

生成AI(ジェネレーティブAI)は、検索の補助・要約・企画・学習支援など、仕事と日常の多くの場面に広がっています。

そのいっぽうで、もっともらしい誤情報=ハルシネーションが実務の品質やコンプライアンスに影響することが見えてきました。

実例(社会的インパクト)

米国では、弁護士がAIの出力した架空の判例を提出し、裁判所から制裁を受けた事例が報告されています。

— つまり、「流暢(リュウチョウ)=正確」ではないことが、公の場で問題化したわけです。

国内の受け止めとガイドライン

日本の公的機関も、**「生成AIの出力には誤りが含まれうる」**と明示し、導入・運用ガイドを公開しています。

要点は、過信しない/確認を前提に使うという運用設計です。

研究・産業界の方向性(軽減策)

- グラウンディング(Grounding/グラウンディング):回答を一次情報(公式原文・統計など)に結びつける考え方。

噛み砕き:足元を“根拠”にくくりつけてから歩くイメージ。 - RAG(ラグ:Retrieval-Augmented Generation/リトリーバル・オーグメンテッド・ジェネレーション):

**検索(リトリーバル)で根拠を集めてから、生成(ジェネレーション)**させる仕組み。

噛み砕き:まず資料室で原本を取り出し、その本を見ながら要約する方法。

背景がつかめたところで、**次章では「日常でどう使いこなすか」**を、すぐ真似できる手順で紹介します。

実生活への応用例

キーワードの読み方

- SIFT(シフト):Stop/Investigate/Find/Trace の頭文字。ネット情報をサッと見極める4手順。

- RAG(ラグ):Retrieval-Augmented Generation。検索→根拠付き生成で**“根拠と回答をセット”**にする仕組み。

① 仕事・学習で

こう使う

- 根拠へジャンプ:AIの示したリンクを必ず開き、本文の該当箇所を確認。

- クロスチェック:ニュース → 省庁・法令・統計 → 学術、と一次情報に近い順で照合。

- 最初の5分はSIFT:

- Stop(ストップ):いったん立ち止まる

- Investigate(インベスティゲイト):誰が言った?(発信元・専門性)

- Find(ファインド):より良い別ソースを探す

- Trace(トレース):一次情報にさかのぼる

噛み砕き:あわてて結論に飛びつかず、“出典→本文→日付”の順で足元固め。

② 子育て・教育で

こう使う

- 親子で**「だ・い・ふく」(だれが言った?/いつ言った?/ふくすうの情報を確認)を声に出す習慣**をつくる。

- 学校や自治体は、入力情報の扱い/出力の確認を含むガイドラインに沿って、情報リテラシー教育を進める。

噛み砕き:“鵜呑み”をやめ、出典を見るクセを育てる学び。

③ クリエイティブ(企画・ライティング)で

こう使う

- アイデア出し・構成はAIで時短。

- 事実主張を含む箇所は根拠リンクを添える。

- 組織導入ならRAGや出典表示UIで、**「根拠→要約」**の順に品質を担保。

噛み砕き:発想は広げる/事実は締める、の“両利き”運用。

メリット/デメリット(要点)

- メリット:アイデア拡張、下書き高速化、調査の当たりがつきやすい。

- デメリット:誤情報リスク、著作権・個人情報への配慮、根拠なき自信への依存。

→ SIFT+RAG+ガイドラインの三点セットで、スピードと正確さを両立しましょう。

実践の型が見えたら、**次章で「誤解と注意点」**を押さえて、失敗を未然に防ぎます。

注意点と誤解しがちな点

誤解①:AIは“わざと嘘をつく”?

→ いいえ。AIは**「自然に見える言葉の並び」を確率で選ぶ**しくみです。

分からないと黙るとは限らず、もっともらしく埋めることがあります。

噛み砕き:わからない道でも“それっぽい方向”を示してしまう案内人。

誤解②:URLを読み込ませたから安全?

→ 要約・抽出の過程で誤読や補完しすぎが起き得ます。

出典本文の該当箇所まで必ず確認しましょう(=根拠へジャンプ)。

誤解③:完全に防げる?

→ 現時点の研究では、軽減は進むが“ゼロ化”は未踏。

過信せず、検証前提で使うのが安全策です。

誤解しないための3ステップ(最小セット)

- 根拠へジャンプ(原文の該当箇所を見る)

- 日付・更新日を確認(いつの情報か)

- 別経路で照合(省庁・学会・一次データ/RAGで根拠提示)

ここまで理解できたら、保存版チェックリストや業務テンプレを手元に置き、明日からの運用に落とし込んでいきましょう。

ロングFAQ

Q5. RAGって導入が難しい?

A. 最小構成なら意外とシンプル。 「(1)検索対象のコーパスを用意(社内ポータル等)→(2)質問に対し検索→(3)抜粋を根拠として要約生成」。**“回答と根拠をセット”**にする発想が本質です。

Q6. 生成AIに“根拠を示して”と言えば直る?

A. 改善はしますが過信は禁物。 出てきた根拠リンクをあなたが開いて確認する工程が不可欠です。

Q7. どこまで確認すれば十分?

A. リスクで決めます。 生活の豆知識なら2ソースで十分。法務・医療・公共性が絡むなら**原典(条文・ガイドライン・論文)**まで到達しましょう。

Q8. 子どもとも使える確認法は?

A. 「だれ?」「いつ?」を声に出すことから。“複数で見る”を一緒に実演し、“鵜呑みにしない”感覚を育てます。

Q9. ハルシネーションは今後なくなる?

A. “完全ゼロ化”は未解決。 研究は進んでいますが、現状は軽減が現実解。だからSIFT+RAG+運用ガイドが実務の定石です。

Q10. 仕事で最初にやるべき1つは?

A. 「根拠へジャンプ」の習慣化。 出典本文の該当箇所と更新日を確認してから採用する——この1アクションだけで、精度は段違いに上がります。

Q11. どの分野が危ない?

A. 固有名・数値・日付・地名が絡むところ。名言・判例・論文など“実在確認が必要な主張”は要注意。

Q12. クリエイティブではどう使い分ける?

A. 発想はAI、事実は出典。 アイデア出しはAIで広げ、事実主張の箇所は必ず根拠リンクで締める“両利き”運用が安全です。

おまけコラム

——ファクトチェックは『だ・い・ふく」

覚え方(復習)

- だ:誰(だれ)が言った? … 発信者・肩書・専門性

- い:いつ言った? … 公開日・更新日・最新版か

- ふく:複(ふく)数で照合 … 独立した別ソースで裏どり

これは海外の定番フレーム SIFT(シフト)

Stop / Investigate / Find better coverage / Trace

を、日常で回しやすい3拍子にしたものです。

カタカナ読み:ストップ/インベスティゲイト(調べる)/ファインド・ベター・カバレッジ(より良い別ソース)/トレース(元情報へ)

面白い小ネタ①:「90秒だ・い・ふく」ストップウォッチ法

- スマホのタイマーを90秒に設定。

- 記事を読んだら、発信者→日付→別ソースの順で一気にチェック。

- 90秒で**“怪しさの初期診断”**ができます。

コツ:検索窓には「サイト名+about」「タイトル+site:go.jp」など、キーワードを短く入れると早いです。

小ネタ②「ホーム画面に3つの“声かけ”」=“押せば確認が始まる”仕掛け

ねらい

- 「だれ?」「いつ?」「別ソース」という“自分への声かけ”ボタンをホームに置き、

1タップで検索アプリが開く → 入力欄にキーワードが入っている/すぐ打てる状態にすること。 - 「あとで確認しよう…」を防ぎ、確認行動の最初の一歩を脳の負担ゼロで起動します。

すぐできる方法(簡単版)

- iPhone/Android 共通:ホームにGoogle検索ウィジェットを置く

- ウィジェットの下にフォルダを作り、名前を**「だれ?」「いつ?」「別ソース」**にして並べる。

- そのフォルダをタップしたら**“いま調べたい語”を入れる**だけ。

- “声かけ”の視覚トリガーを作るのがポイント。

小ネタ③「検索演算子ちょい足し」=“探す箱を小さくする”技

ねらい

- ノイズの多い検索結果から信頼寄りの候補だけを素早く出す。

- 場所・形式・タイトルで的を絞る。

よく使う3つ(読み方と意味)

- site:(サイト)…ドメインを絞る

- 例:

site:go.jp(官公庁) /site:ac.jp(大学)

- 例:

- filetype:(ファイルタイプ)…資料の形式を絞る

- 例:

filetype:pdf(報告書・原本PDFがヒットしやすい)

- 例:

- intitle:(インタイトル)…タイトルに含む語で絞る

- 例:

intitle:統計(統計と明示されたページを狙い撃ち)

- 例:

使い方の型(そのまま真似OK)

- 官公庁のPDF原本を探す:

〇〇の数値 site:go.jp filetype:pdf - 大学や研究機関の見解を探す:

〇〇 調査 site:ac.jp filetype:pdf - タイトルに統計を含むページを探す:

〇〇 統計 intitle:統計

「探す箱を小さく」すると、目的地に最短で着くようになります。

次は、AIの速さと一次情報の確かさを順番で両立させる方法です。

小ネタ④「“ウワサ”と“データ”の二刀流」=“速さと確かさ”の両立

ねらい

- Step1(ウワサ):AIの速さで輪郭・争点・用語を洗い出す。

- Step2(データ):一次情報(公式原文・統計・学会資料)で裏どりして、結論は根拠つきにする。

やり方(具体フロー)

- AIに聞く(ウワサの形)

- 例:「〇〇の論点と、賛否の主張を3つずつ教えて」

- 例:「このトピックの“定義・原因・影響・対策”を見出し化して」

→ 争点・キーワードをサッと把握(=地図作り)。

- 一次情報で裏どり(データの形)

- 先ほどのキーワードを検索演算子で深掘り:

site:go.jp filetype:pdf(官公庁PDF)site:ac.jp(大学・研究)intitle:統計(タイトルに統計)

- 原文の該当箇所を開き、数値・年月日・注記を確認。

- もしAIの要約と食い違う点があれば、AIに根拠つきで再質問:

- 例:「この数値、総務省のPDFでは△△です。どこでズレましたか?修正して、根拠URLと該当ページ番号を示してください。」

- 先ほどのキーワードを検索演算子で深掘り:

- メモ化(再利用のため)

- チェック済みのURLと引用箇所の抜粋をメモアプリに保存(次回の自分への根拠)。

- 必要ならRAG型のツール(社内検索→根拠つき回答)で再利用。

この手順なら、AIのスピードを活かしつつ、意思決定は一次情報で堅くできます。

ここまでできれば、“ハルシネーションに振り回されない”日常運用が完成です。

小まとめ

- 小ネタ②:ホームに「だれ?/いつ?/別ソース」。押せば確認が始まる。

- 小ネタ③:

site: / filetype: / intitle:で探す箱を小さく。 - 小ネタ④:ウワサ(AIで輪郭)→データ(一次情報で確証)の順で速さと確かさを両立。

「だ・い・ふく」を楽しく回すコツを掴めました。

ここからはまとめ・考察で、学んだことをあなたの日常判断にどう落とすかを整理します。

まとめ・考察

要点の再確認

- ハルシネーション(Hallucination/ハルシネーション):

生成AIが流暢なのに事実と異なる、あるいは根拠に不忠実な内容を出してしまう現象。

現状、完全防止(ゼロ化)は未解決。だから確認前提で使う。 - 運用で減らす:

SIFT/だ・い・ふく、根拠へジャンプ(出典本文の該当箇所)、

RAG(ラグ)・**グラウンディング(根拠に結びつける設計)で“根拠と回答をセット”**に。

考察

AIは**「可能性を言語化する装置」です。

仮説を速く・幅広く提示してくれる一方、真偽の確定は人の役割に残ります。

これからの情報リテラシーは、AI×人間の二人三脚——

AIで仮説を広げ**、人が証拠で締める。この往復が、意思決定の質を底上げします。

AIは**“うっかり名探偵”**。推理(文章生成)は切れ者でも、証拠集め(根拠確認)はついサボりがち。

だから私たちは“証拠係”を自任しましょう。

だ・い・ふくの3拍子を鳴らせば、名探偵は頼れる相棒に変わります。

読者への問いかけ

- 「だれ?いつ?別ソース?」を声に出してから、ボタンを押してみませんか。

- 明日の会議で、**“根拠へジャンプ”**を1回だけでも実践しませんか。

- それだけで、“もっともらしさ”に振り回されない自分に近づけます。

最後に、信頼できる情報源や書籍をまとめます。

“根拠の地面”を固める道具箱として、ご活用ください。

速さは武器です。

でも、速さの先にある“確かさ”こそ、あなたの信頼をつくります。

だ・い・ふくでひと呼吸。RAGで根拠を結び、根拠へジャンプで地面を固める。

今日のモヤモヤは、きっと明日の自信に変わります。

——さあ、次の章で“根拠の道具箱”を整えましょう。

追補(保存・共有しやすい実践パート)

A. 【保存版】だ・い・ふく ミニカード

- だ(誰):発信者・肩書は?

- い(いつ):公開日・更新日は?

- ふく(複数):独立した別ソースで裏どりした?

ワンモア:根拠へジャンプ(出典本文の該当箇所を必ず開く)

B. “根拠へジャンプ” 3ステップ

- 本文の該当箇所を探す(ページ内検索

Ctrl/Cmd + Fでキーワード) - 更新日・版数を確認(古い情報に注意)

- 別経路で照合(官公庁・学会・一次データ/RAGで根拠提示)

C. 検索演算子チート(短く覚える)

site:go.jp… 官公庁filetype:pdf… 原本のPDFintitle:統計… タイトルに“統計”

例:少子化 対策 site:go.jp filetype:pdf

D. NG→OK(並列表)

NG「URLを読み込ませたから安心」

OK「要約の元ページと別経路で検証」

NG「AIが言ってるから」

OK「出典本文+更新日を確認して採用」

NG「1サイトだけ」

OK「三角測量(公的資料+学会+主要紙)」

更に学びたい人へ

初学者におすすめ

『情報リテラシー入門 2025年版』

裏 和宏 ほか

- 著者:裏 和宏ほか(大学・実務の視点から基礎力を体系化)

- 本の特徴:2025年版の最新テキスト。検索・評価・引用の基本を、学校や仕事でそのまま使える形で整理。章立てが素直で最短で基礎を固めたい人向け。

- おすすめ理由:本記事で扱った**「だ・い・ふく」やSIFTの実践**に直結する“情報の探し方・確かめ方の土台”を一気に作れるから。まず1冊で迷わない入門書です。

中級者向け

『ファクトチェック最前線―フェイクニュースに翻弄されない社会を目指して』

立岩 陽一郎

- 著者:元NHK記者・ファクトチェック運動の国内草分けの一人。現場取材と実務経験が豊富。

- 本の特徴:海外と日本国内の実例・手順・運用ルールを整理。**「あなたもファクトチェッカーに」**と読者へ具体的行動を促す構成。Kindle版もあり入手容易。

- おすすめ理由:ニュース現場での検証プロセスを学べるため、日常のSIFTを一段深いレベル(裏どりの当て方・判断の癖)に引き上げられるから。

全体におすすめ

『AI vs. 教科書が読めない子どもたち』

新井 紀子

- 著者:数理・教育の研究者。東ロボくん実験でAIの得手不得手を可視化した第一人者。

- 本の特徴:AIの限界と人間の読解の役割分担を平易に解説。紙・Kindle・Audibleと選択肢が広く、学びのスタイルに合わせやすい。

- おすすめ理由:本記事のテーマである**「AIはもっともらしく語れても、真偽判断は別」**という前提を、教育と社会の文脈で納得感高く理解できるから。

疑問が解決した物語

電車はトンネルを抜け、夕日の光が窓に戻ってきます。

あなたは深呼吸して、ホーム画面の**「だれ?」「いつ?」「別ソース」のボタンを順に押しました。

まずは根拠へジャンプ**。AIのリンクを開き、本文の該当箇所を検索(Ctrl/Cmd + F)。——見当たらない。

つぎに**「いつ?」で日付を確認。——古い版の記事でした。

最後に「別ソース」。site:go.jp filetype:pdfで探した公式PDFを開くと、改正後の条文に例外の条件**が明記されています。

あなたはAIに根拠URLと該当ページ番号を示して問い直し、

「この情報で要点を修正して、出典つきでまとめて」と依頼。

返ってきた新しい要約は、条文の言い回しと日付が正しく、出典リンクも添えられていました。

胸のざわつきは、安心に変わります。

人物の行動(対応方法)

- だ・い・ふくで確認(だれ/いつ/複数)。

- 根拠へジャンプして本文の該当箇所を照合。

- 別経路(省庁PDF)で最新版を確認。

- AIには根拠を添えて再質問し、間違いは修正して保存。

教訓

“もっともらしさ”はゴールではない。

根拠に触れたときにこそ、はじめて答えは自分のものになる。

電車が駅に滑り込むころ、あなたはレポートの最終行に出典を打ち込み、送信ボタンを押しました。

スピードはAI、確かさはあなた。——その二人三脚が、仕事の新しい標準になっていきます。

読者への問いかけ

次にモヤッとしたら、あなたも**「だれ?」「いつ?」「別ソース」**から始めてみませんか。

最初の90秒を確認に使うだけで、結果はどれだけ変わるでしょう。

文章の締めとして

ここまで読んでくださり、ありがとうございます。

今日の学びはシンプルです。速さはAI、確かさはあなた。

迷ったら、まず**「だ・い・ふく」(だれ?/いつ?/複数)でひと呼吸。

そして根拠へジャンプして、原文の該当箇所と更新日を確かめる。

必要ならRAG(検索→根拠つき生成)の考え方で、“回答と根拠をセット”**にして使う。

——それだけで、明日の判断はもっと強く、穏やかになります。

このページは保存版としてブックマークしておいてください。

次に違和感に出会ったとき、**ホームの「だれ?」「いつ?」「別ソース」**から始めれば、

“もっともらしさ”に振り回されない自分に、必ず近づけます。

注意補足

最後に小さな免責を。

本記事は、筆者が信頼できる情報源をもとに注意深く確認して作成しましたが、

研究や運用の知見は日々更新されます。他の見解もありえます。

だからこそ、結論を自分の手で確かめる習慣を、今日からいっしょに育てていきましょう。

答えはここで終わりではありません。ハルシネーションを遠ざけるのは、自分で根拠へジャンプする一歩。

気になったら、一次情報と良書で、あなたの結論を磨いてください。

最後まで読んでいただき、

本当にありがとうございました。

それでは、ハルシネーション(幻覚)に惑わされず、いつも**根拠を“ハル(貼る)シネーション”**で——ご一読ありがとうございました。

コメント